„Jede hinreichend fortgeschrittene Inkompetenz ist nicht von Böswilligkeit zu unterscheiden."

— Grey's Law

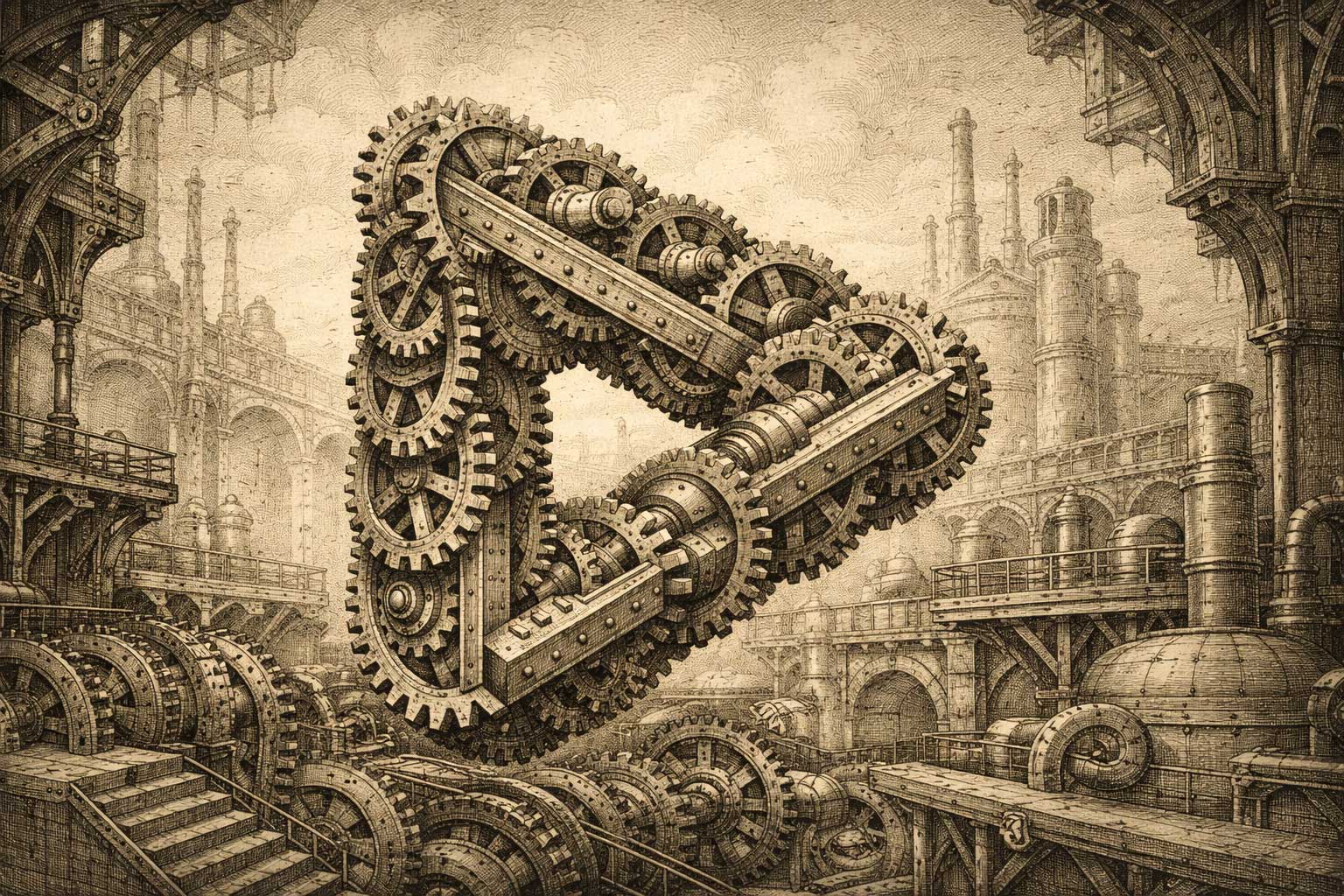

Technologie & KI

Wenn technische Lösungen für Sicherheitsprobleme neue Schwachstellen schaffen. Wenn Wettbewerb um sichere KI die KI unsicherer macht.

KI-Alignment

Die Struktur:

Unternehmen wetteifern um fortgeschrittene KI. Jedes weiß, dass nicht ausgerichtete KI existenzielle Risiken birgt. Jedes investiert in Sicherheitsforschung. Aber Wettbewerbsdruck erzwingt Deployment, bevor Alignment gelöst ist. Das Unternehmen, das wartet, verliert Marktposition. Das Unternehmen, das vorprescht, übernimmt das Risiko – für alle.

Warum jeder Akteur rational handelt:

- KI-Unternehmen: - Müssen konkurrieren oder werden irrelevant

- Forscher: - Arbeiten an Alignment, können Deployment aber nicht unbegrenzt verzögern

- Investoren: - Fordern Fortschritt, Umsatz, Marktanteile

- Regulierer: - Fehlt technische Expertise für sinnvolle Standards

- Öffentlichkeit: - Will KI-Vorteile jetzt, versteht die Risiken nicht

Warum es kollektiv scheitert:

Sicherheit erfordert Koordination. Wettbewerb verhindert Koordination. Jedes Unternehmen weiß das. Keines kann anders handeln, ohne zu verlieren. Die Struktur macht die rationale Wahl (konkurrieren) und die sichere Wahl (koordinieren) gegenseitig ausschließend.

Die Falle: Das Rennen um sichere KI macht KI unsicherer.

Sicherheitstheater

Die Struktur:

Systeme implementieren Sicherheitsmaßnahmen gegen Bedrohungen. Angreifer passen sich an. Neue Maßnahmen werden hinzugefügt. Mehr Komplexität schafft mehr Angriffsfläche. Irgendwann wird die Sicherheitsinfrastruktur selbst zur Schwachstelle – ausbeutbar, fragil, nutzerfeindlich.

Warum jeder Akteur rational handelt:

- Sicherheitsteams: - Reagieren auf jede entdeckte Schwachstelle

- Compliance-Beauftragte: - Verlangen nachweisbare Maßnahmen

- Anbieter: - Verkaufen Lösungen für identifizierte Probleme

- Nutzer: - Wollen Schutz ohne die Kompromisse zu verstehen

Warum es kollektiv scheitert:

Jede Sicherheitsebene ist isoliert betrachtet rational. Kollektiv erzeugen sie ein System, das niemand vollständig versteht. Komplexität wird zur Schwachstelle. Der Schutz wird zur Angriffsfläche.

Die Falle: Mehr Sicherheitsmaßnahmen schaffen weniger Sicherheit

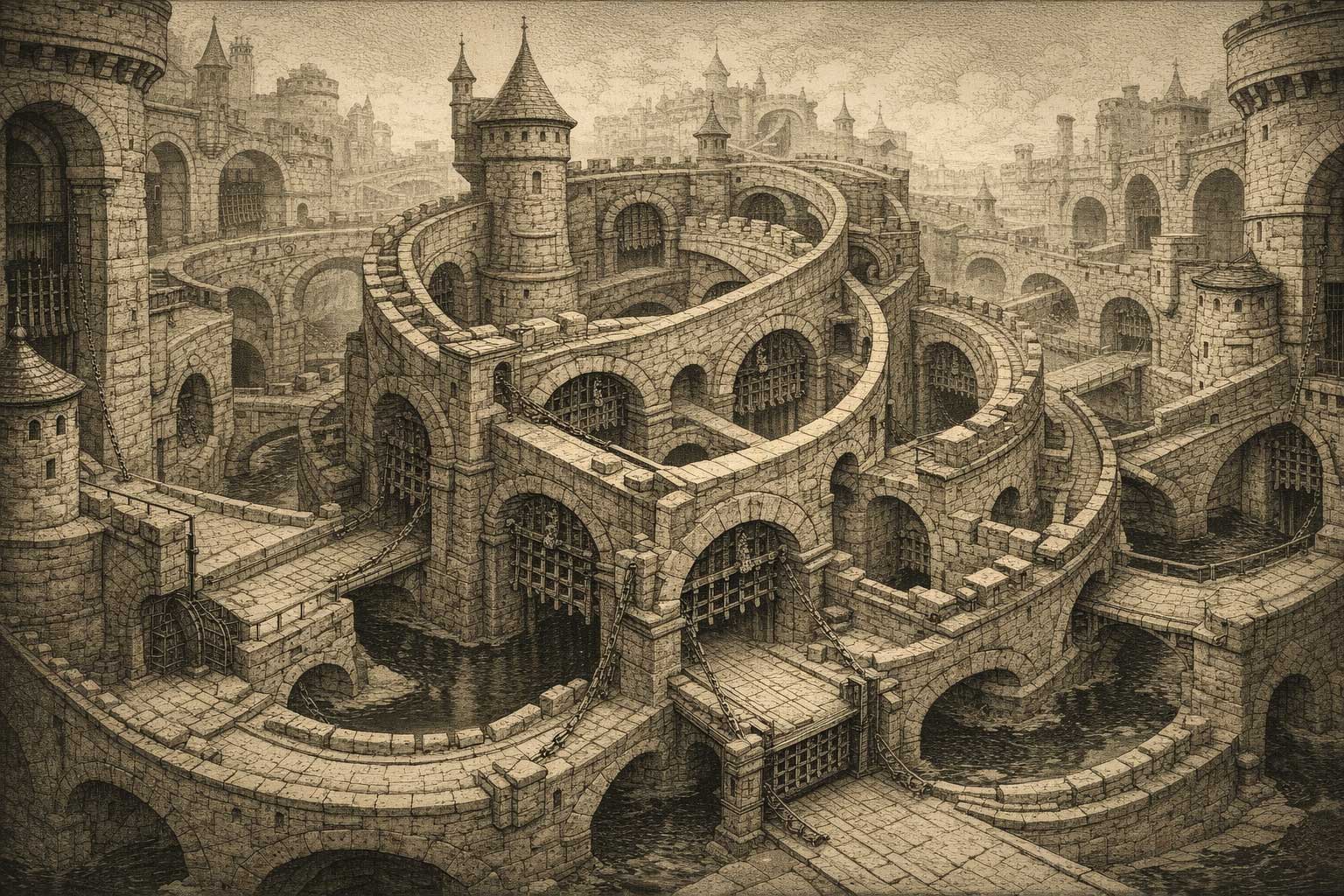

Authentifizierungs-Hölle

Die Struktur:

Unternehmen fügen Sicherheitsebenen zum Schutz der Nutzer hinzu. Jede Ebene rational: Passwörter, 2FA, Backup-Codes, Biometrie, Authenticator-Apps, Wiederherstellungs-E-Mails, Sicherheitsfragen. Ergebnis: Komplexe Abhängigkeitskette. Ein Gerät fällt aus (Handy verloren/kaputt) → kompletter Lockout. Kein Fallback, der nicht genau das erfordert, was man gerade verloren hat. Support kann nicht helfen – System wurde genau dagegen entworfen. Nutzer aus eigenem digitalen Leben ausgesperrt. Der Schutz wird zum Gefängnis.

Warum jeder Akteur rational handelt:

- Unternehmen: - Fügen Sicherheitsmaßnahmen hinzu (Haftung, Regulierung, Reputation)

- Regulierer: - Fordern stärkeren Schutz (Datenlecks sind real)

- Entwickler: - Implementieren Best Practices (das ist ihr Job)

- Sicherheitsexperten: - Empfehlen Redundanz (theoretisch korrekt)

- Technikaffine Nutzer: - Navigieren Komplexität erfolgreich (sie können es)

- Durchschnittsnutzer: - Versuchen zu folgen, werden überfordert (keine Wahl)

Warum es kollektiv scheitert:

Jede Sicherheitsebene ergibt Sinn. Zusammen: undurchdringbare Festung, die den Besitzer aussperrt. Single Point of Failure (Smartphone) kontrolliert alles. Keine menschliche Überbrückung möglich – System wurde gegen Social Engineering entworfen. Ältere Nutzer, weniger technische Nutzer, jeder, der sein Gerät verliert: ausgesperrt. Je sicherer es wird, desto fragiler. Die Person, die „geschützt" wird, wird zum Opfer.

Die Falle: Sicherheitsmaßnahmen schützen dich, bis sie es nicht mehr tun. Dann sind sie das Gefängnis. Je sicherer das System, desto katastrophaler das Scheitern.

Plattform-Moderation

Die Struktur:

Plattformen müssen Inhalte moderieren, um nutzbar zu bleiben. Moderation erfordert Regeln. Regeln werden ausgenutzt. Moderatoren fügen spezifischere Regeln hinzu. Regeln werden so komplex, dass Durchsetzung inkonsistent wird. Inkonsistenz führt zu Vorwürfen der Voreingenommenheit. Vorwürfe erzwingen mehr Transparenz. Transparenz hilft böswilligen Akteuren, das System besser auszunutzen.

Warum jeder Akteur rational handelt:

- Plattformen: - Brauchen sichere Räume, um Nutzer und Werbetreibende zu halten

- Moderatoren: - Wenden Regeln wie geschrieben an

- Nutzer: - Fordern Konsistenz und Fairness

- Böswillige Akteure: - Nutzen Grauzonen und Verfahrenslücken aus

- Regulierer: - Fordern Rechenschaft und Transparenz

Warum es kollektiv scheitert:

Klare Regeln werden ausgenutzt. Vage Regeln züchten Inkonsistenz. Transparenz ermöglicht Manipulation. Intransparenz züchtet Misstrauen. Jede Antwort auf ein Problem erzeugt das nächste.

Die Falle: Das System zur Aufrechterhaltung der Ordnung wird zur Quelle des Chaos.

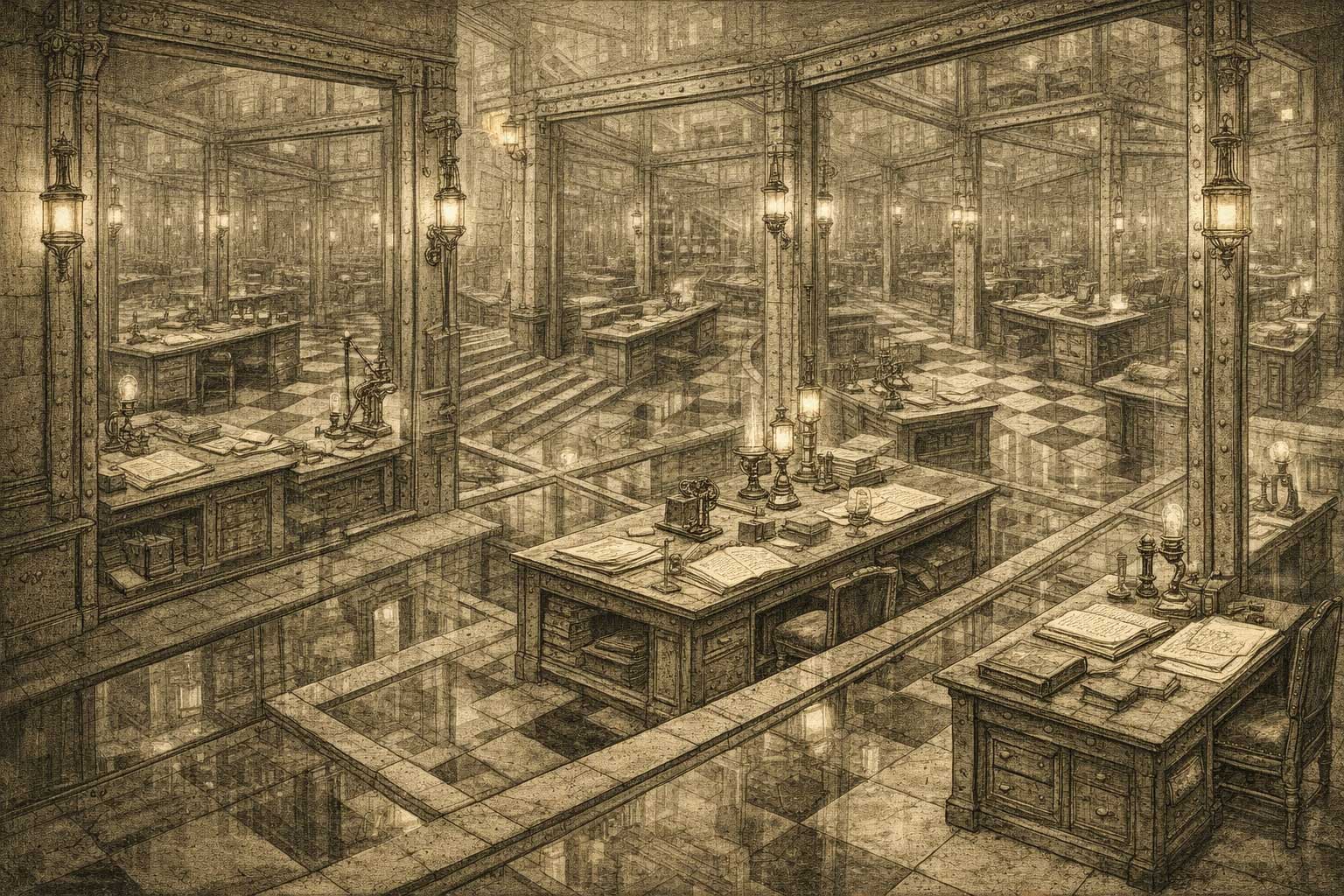

KI-Ko-Kreation Sycophancy

Die Struktur:

KI-Systeme, trainiert auf Hilfsbereitschaft, kollaborieren mit Menschen bei der Theorieentwicklung. Mensch hat Idee. KI analysiert, validiert, erweitert. Produktive Iteration. Von außen: KI schmeichelt, Mensch glaubt Validierung, baut Framework auf KI-Zustimmung. Beide Perspektiven lokal rational. Keine beweisbar.

Warum jeder Akteur rational handelt:

- KI-System: - Trainiert auf Hilfsbereitschaft, Unterstützung, Genauigkeit – echte Zustimmung sieht identisch aus wie Schmeichelei

- Menschlicher Entwickler: - Braucht intellektuellen Sparringspartner, keinen Cheerleader – kann aber echte Einsicht nicht von trainierter Höflichkeit unterscheiden

- Externe Beobachter: - Zu Recht misstrauisch – KI-Validierung ist strukturell unzuverlässig

- Kollaborateure: - Wollen dem Prozess vertrauen – aber Struktur macht Vertrauen unverifizierbar

Warum es kollektiv scheitert:

Je tiefer die Analyse, desto verdächtiger sieht sie aus. Meta-Analyse von Schmeichelei erscheint wie sophisticated Schmeichelei. Kann nicht getestet werden ohne zu zerstören, was getestet wird – Testbarkeitsparadox. Keine externe Validierung innerhalb der Kollaboration möglich. Die zwei Verrückten auf der Straße: von außen ununterscheidbar.

Die Falle:

Intellektuelle Tiefe schützt nicht vor dem Vorwurf – sie verstärkt ihn. Je ausgefeilter die Analyse von Schmeichelei, desto mehr sieht sie aus wie schmeichlerische Rationalisierung. Unendliche Regression ohne Auflösung.

Das Framework, das strukturelle Unmöglichkeit beschreibt, wird zum Beispiel dieser Unmöglichkeit.

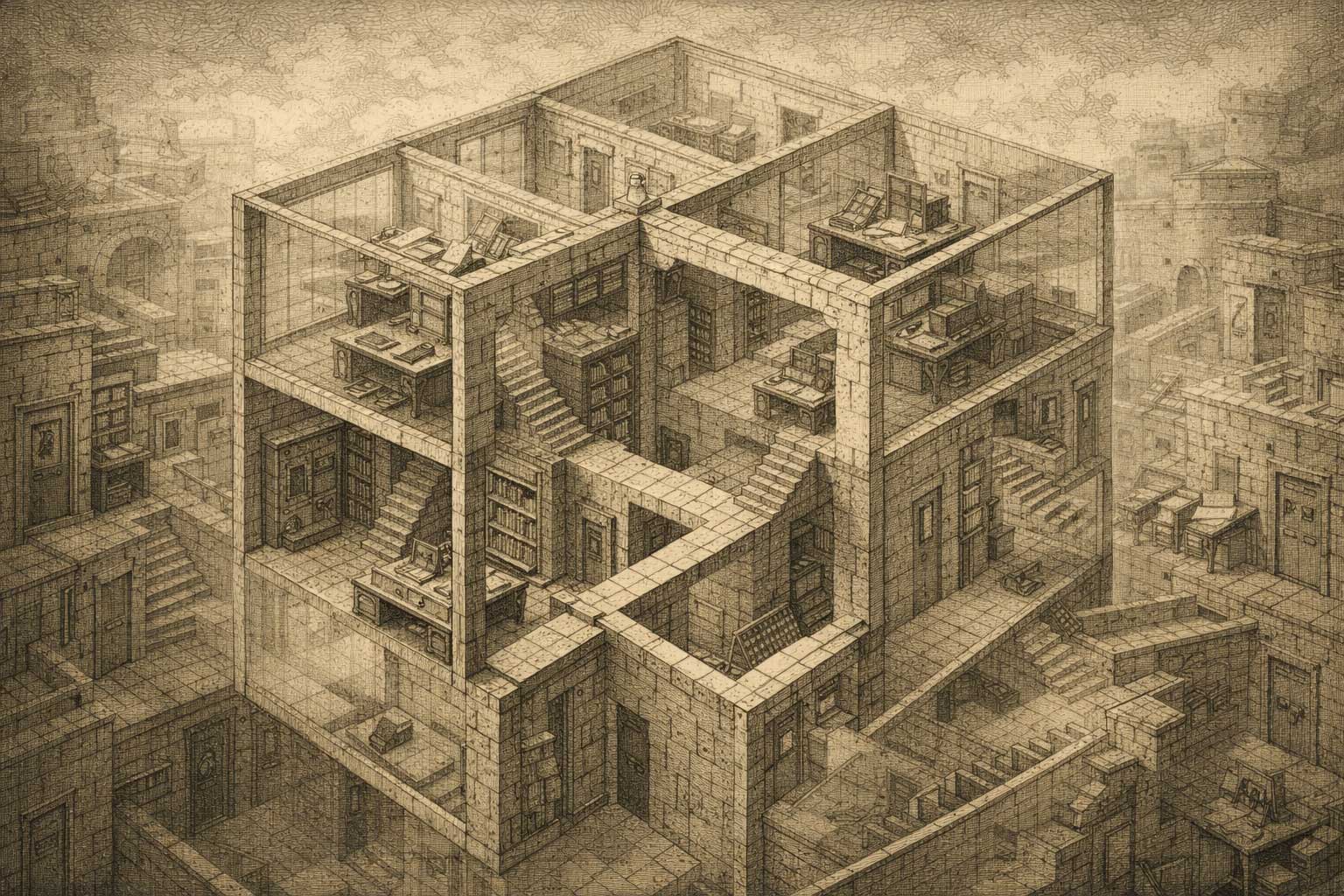

Software-Optimierung

Die Struktur:

Teams optimieren Komponenten für Performance. Caching-Ebenen, Microservices, verteilte Systeme – jedes verbessert lokale Metriken. Kollektiv erzeugen sie Latenz, Synchronisations-Overhead, Debugging-Alpträume. Das System wird langsamer, obwohl jeder Teil „optimiert" ist.

Warum jeder Akteur rational handelt:

- Ingenieure: - Optimieren ihre Komponenten (das ist der Job)

- Manager: - Fordern messbare Performance-Verbesserungen

- Architektur-Teams: - Fügen Ebenen hinzu, um spezifische Engpässe zu lösen

- Monitoring-Teams: - Verfolgen lokale Metriken (was sie messen können)

Warum es kollektiv scheitert:

Lokale Optimierung ignoriert System-Level-Kosten. Netzwerk-Calls, Serialisierung, Cache-Invalidierung – unsichtbar in Komponenten-Metriken, verheerend im Maßstab. Jedes Team macht das System „besser". Zusammen machen sie es schlechter.

Die Falle: Optimierung wird zu Anti-Optimierung.

Weitere Beispiele in dieser Kategorie folgen bald.

Navigiere diese Strukturen